Après vous être informé sur le machine learning, vous êtes-vous demandé quelles étaient ses performances ? Car si ce système d’apprentissage peut être vu comme un âne bâté pour un processeur chargé de traiter des informations, alors le réseau de neurones est la carotte qui le fait avancer. En effet, pour qu’un système soit vraiment intelligent, il ne doit pas être programmé pour réaliser une tâche, mais plutôt pour apprendre à réaliser cette tâche. D’où la nécessité du deep learning, qui s’inspire du fonctionnement de nos neurones et de leurs réseaux, et permet au système de trouver des motifs répétés dans les données qui lui sont fournies, pour apprendre une tâche.

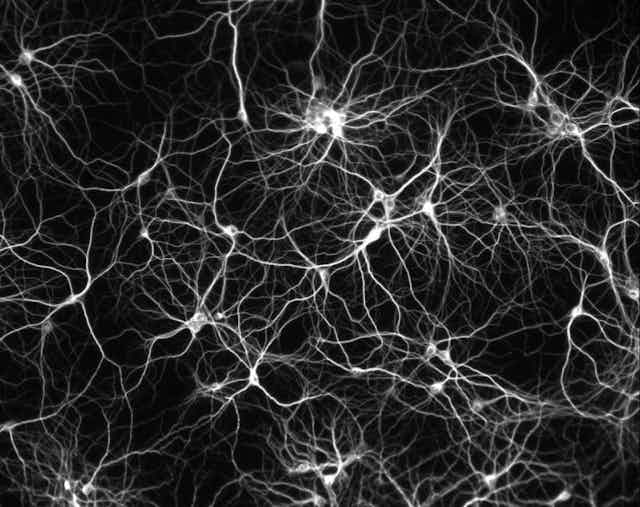

Les réseaux de neurones, ou plus précisément, les réseaux de neurones artificiels, sont des dispositifs qui permettent de traiter l’information. Et s’ils portent ce nom, c’est parce qu’il s’agit d’algorithmes, d’instructions machine dont la structure rappelle celle du cortex cérébral, mais à plus petite échelle.

Leur origine remonte à 1957, avec l’invention du Perceptron par Frank Rosenblatt : un réseau de neurones qui prend modèle sur la structure de la cellule nerveuse, en tenant compte également des dendrites – courts prolongements du neurone à travers lesquels passent des informations sous forme électrochimique.

Dans le modèle des neurologues Warren McCulloch et Walter Pitts, les précurseurs des réseaux de neurones formels, la variable d’entrée est binaire : elle ne prend pour valeur que 0 ou 1. Chaque valeur d’entrée est ensuite pondérée de son poids, et la somme des entrées pondérées est introduite dans le modèle. Le Perceptron intègre donc plusieurs entrées binaires (D1, D2… DN), et produit en sortie une donnée binaire unique, qui indique si le seuil d’activation est atteint ou pas. A savoir, 0, si le résultat est plus petit ou égal au seuil, et 1, dans le cas contraire.

Partant de cette première version, le Perceptron a été amélioré de manière à ne plus limiter les valeurs d’entrée et la fonction de pondération aux valeurs binaires, mais à prendre en compte toutes les valeurs réelles. En faisant varier les poids et le seuil, nous pouvons obtenir des modèles de prise de décision différents. La donnée de sortie d’une couche cachée peut également être insérée dans une autre couche cachée du Perceptron.

Dans ce Perceptron multicouche, la première couche est assignée à des décisions très simples, en pondérant les données d’entrée. Les données de sortie sont ensuite traitées dans une seconde couche, dont les décisions sont pondérées par les résultats de la première, et se situent donc à un niveau plus complexe et abstrait. Le processus de décision gagne encore en complexité avec une troisième couche, et ainsi de suite. Au final, plus le nombre de couches d’un Perceptron est élevé, meilleure est sa capacité de prise de décision. Et elle est applicable à de nombreux domaines.

Mais alors, pourquoi le deep learning a-t-il mis si longtemps à connaître un certain succès ? Sans doute fallait-il attendre des progrès en matière de puissance de calcul, et c’est désormais chose faite : on peut aujourd’hui traiter un grand nombre des données d’entrée et de sortie rapidement. Depuis 2009, des circuits intégrés spécialisés (ASICs) et des processeurs graphiques (GPUs) sont également utilisés pour les calculs pour les modèles à réseaux de neurones. Et de fait, le deep learning et les réseaux de neurones artificiels ont transformé le monde de l’intelligence artificielle ces dernières années, en améliorant considérablement son « intelligence ».

En disposant de très grands jeux de données et d’une forte puissance de calcul, les machines peuvent désormais reconnaître des objets, traduire des discours, s’auto-entraîner à identifier des motifs complexes, apprendre à définir une stratégie et gérer des imprévus en temps réel. Ainsi, le deep learning suscite-t-il l’intérêt des entreprises chargées de travailler à la détection d’armes dissimulées dans des bagages, dans les services des douanes des ports et aéroports.

Dans le domaine de la finance, le monde des traders s’y intéresse aussi pour prédire l’évolution des marchés. Sans compter que les gestionnaires d’actifs utilisent le deep learning pour identifier des « patterns » (motifs) en croisant plusieurs sources de données comme des factures de transport, des retours de clients sur Twitter et les discours des membres de la Réserve fédérale pour n’en nommer que quelques-unes. Enfin, des « patterns » peuvent également être trouvés à partie de données non-identifiées. Et in fine, en appliquant les méthodes du deep learning à la finance, les chercheurs ont pu produire de meilleurs résultats qu’avec les modèles économiques et statistiques standards.