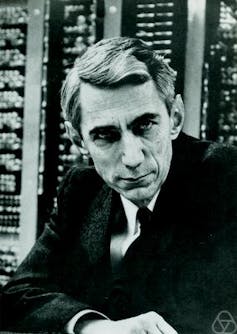

Nous poursuivons avec cet article la suite de notre série sur le cycle « Un texte, un mathématicien ». Aujourd’hui, Claude Shannon et le texte fondateur de la théorie mathématique de l’information.

L’article en deux parties de Claude Shannon « Une théorie mathématique de la communication » paraît en 1948 ; ce texte (dont la réédition en français est annoncée par les éditions Cassini), représente une avancée conceptuelle parmi les plus importantes du XXe siècle ; il a jeté les bases de notre société connectée, des réseaux omniprésents (Internet, téléphone, satellites, etc.) où circulent des milliards de milliards de données diverses. Car quand nous et surtout nos enfants vitupérons contre la faible « bande passante » qui ralentit les téléchargements, nous vivons dans la pensée de Shannon.

Pour Claude Shannon, cet ingénieur et mathématicien américain dont on fête cette année le 100e anniversaire de naissance, il s’agissait de donner un sens mathématique précis à la notion d’information, et donc de poser les bases de la transmission de cette information. Dissipons tout de suite les malentendus : l’information dont il s’agit ici n’a pas de contenu sémantique, pas de signification ; en revanche, le contenu sémantique dépend évidemment de l’information au sens ou on l’utilise ici.

Shannon a fait ses études en génie électrique à l’université du Michigan puis au MIT. Dès 1937, dans sa thèse de master, il montre l’importance d’une théorie mathématique, l’algèbre de Boole, dans la conception des circuits électriques ; en 1940, il fait sa thèse sur l’application des mathématiques à la génétique mendélienne (rappelez vous, les petits pois de Gregor Mendel…). Ensuite, il entre aux Laboratoires Bell où il restera jusqu’en 1956, avant de devenir professeur au MIT.

Incidemment, jusqu’aux années 1990, une très grande société privée, le géant américain du téléphone ATT, pouvait considérer qu’il était essentiel pour son développement d’avoir en son sein des laboratoires de recherche fondamentale. Et quels laboratoires ! Les « Bell Labs » comptent à leur actif 8 prix Nobel, 2 prix Turing. Pour prendre un exemple, c’est aux Bell Labs, en 1947, à la même époque que les travaux de Shannon, que travaillaient trois physiciens de premier plan, Bardeen, Brattain et Shockley qui ont élucidé les propriétés quantiques de certains matériaux, inventant ainsi le transistor – ce pour quoi ils ont reçu le prix Nobel en 1956.

En 1948, l’informatique en est à ses débuts. Certes, il y a eu des travaux précurseurs, comme la machine à calculer de Pascal au XVIIe siècle, le métier à tisser inventé par Jacquard en 1801, la « machine analytique » développée par Ada Lovelace et Charles Babbage dans les années 1830. Mais pour passer à l’informatique, il fallait au moins trois ingrédients supplémentaires : un système de codage symbolique qui remplacera les cartes perforées des machines anciennes, l’électricité puis l’électronique, et sur le plan purement conceptuel, la logique mathématique.

Avec des 0 et des 1 on peut représenter n’importe quel nombre en système « binaire », comme si, au lieu de 10 doigts, nous n’en avions que 2. Pas seulement les nombres, mais aussi les lettres, les couleurs, les niveaux de gris, les fréquences et donc les images, les sons, la musique… Et comme, réciproquement, toute suite de 0 et de 1 peut être interprétée comme un nombre, on ouvre la voie du calcul. Voilà pour le codage symbolique.

Les progrès des circuits électriques, et l’électronique qui émerge dans les années 1930 sont la deuxième condition nécessaire. Ils prennent appui sur le codage zéro-un. 1 : le courant passe. 0 : il ne passe pas.

Enfin, il n’y aurait pas d’informatique dans les années 1940 sans le développement de la logique mathématique entre la fin du XIXe et les années 1930, avec l’article fondateur de Turing en 1936, et les travaux de von Neumann, Turing et d’autres après la guerre. C’est dans ce contexte que Shannon mène ses recherches. Il est parfaitement au courant de la révolution informatique naissante ; il a d’ailleurs rencontré von Neumann à Princeton en 1940 et Turing aux Bell Labs en 1943.

En 1948, radio, télévision, magnétophones et disques existent depuis longtemps. Le stockage et la transmission de l’information utilisent des processus analogiques, basés sur la physique. Or, les ingénieurs comme les utilisateurs savent bien qu’il y a des parasites dans le stockage et la transmission, comme on peut encore s’en rendre compte aujourd’hui en écoutant de vieux disques ou en regardant des films anciens. La question de la transmission des signaux devient alors primordiale.

On va pouvoir progresser à partir de ce principe unique : l’information, quelle qu’elle soit, nombre, texte, image, son… est théoriquement toujours codée de la même manière sous forme d’une suite de 0 et de 1. Shannon comprend tout le parti qu’on peut tirer d’une telle représentation : on peut donner un sens précis à la quantité d’information, à partir du nombre de symboles 0 ou 1 utilisés, de « bits » (abréviation de « binary digit ») selon le terme introduit par Shannon dans son article de 1948.

Faisons un petit calcul sur le codage des textes : 26 lettres de l’alphabet, en majuscules et minuscules, 10 chiffres, un certain nombre de signes de ponctuation, l’espace, et un certain nombre de symboles : le clavier d’un ordinateur américain permet de représenter 127 symboles différents, qu’on peut donc coder avec les nombres allant de 1 à 127 (c’est le codage standard ASCII inventé en 1963).

Si l’on représente un nombre entre 1 et 127 en base 2 avec sept chiffres (0 ou 1), 127 s’écrit 1111111. Si l’on développe : une lettre est de taille 7, une page de 2500 signes de taille 17500, et donc un livre de 250 pages est de taille 4 375 000 bits. Plutôt que des bits, il est courant d’utiliser des ensembles de 8 bits, qu’on appelle octets ; compté en octets, un livre de 250 pages (en ne comptant que le texte, hors mise en page) a une taille d’environs 550 000 octets, soit 550K). Notons au passage qu'un texte de 250 pages équivaut à une seule photo en définition correcte : étonnant !

Ayant donné un sens précis à la quantité d’information, Shannon peut alors énoncer une limite théorique à la vitesse de transmission de l’information, en fonction du débit ; la réponse est toute simple en apparence : la limite supérieure est égale au quotient du débit (mesuré en bits par seconde) par l’information (mesurée en bits par symbole – dans l’exemple ci-dessus, le symbole « lettre » vaut 7 bits).

Ça paraît simple ! Mais il faut prendre en compte d’autres éléments : la succession des symboles n’est pas aléatoire ; la transmission n’est pas parfaite, mais induit des erreurs ; l’information a été codée pour obtenir des bits, etc. Les concepts auxquels Shannon a du faire appel sont issus de la théorie mathématique des probabilités et de la physique ; dans sa théorie de l’information, apparaît en particulier la notion d’entropie, centrale en physique statistique, qui mesure le désordre. Un texte écrit par un auteur se traduit par une suite de lettres plus ordonnée que la suite de symboles tapés par un singe sur un clavier de manière aléatoire !

La théorie de l’information a connu un développement prodigieux depuis 1948 : on a tellement amélioré les dispositifs techniques (taille des processeurs, fibres optiques…), les moyens de codage, les techniques de filtrage du bruit, qu’on a pu penser que la limite de Shannon cessait d’être un problème. En réalité, les recherches récentes, dont celle menée par Josselin Garnier, notre conférencier de mercredi, permettent d’extraire du « bruit », qu’on pensait inutile, voire nocif, des informations pertinentes.

La conférence de Josselin Garnier, « Claude Shannon et l’avénement de l’ère numérique » se tiendra mercredi 14 avril à 18h30 au grand auditorium de la Bibliothèque nationale de France.