Il y a environ deux mille milliards de galaxies observables dans l’Univers, et l’évolution de chacune est sensible à la présence de toutes les autres. Face à un tel gigantisme, comment comprendre et calculer l’évolution de l’Univers ?

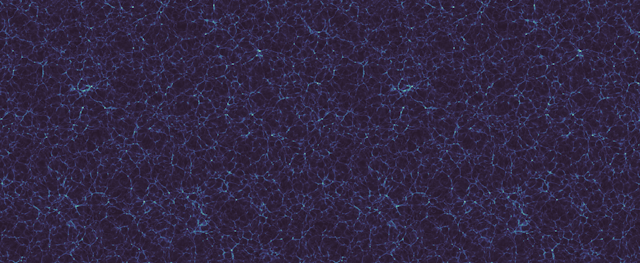

Outre les étoiles et galaxies, ces objets que nous pouvons voir, l’Univers est rempli d’objets invisibles à l’œil nu, par exemple les pulsars qui émettent dans des domaines de fréquences invisibles. Il y a aussi des objets qui, par définition, n’émettent et n’absorbent pas de lumière, et qu’il est donc difficile d’observer – ce sont la matière noire et l’énergie noire. Ces objets visibles et invisibles créent des amas dans l’espace qui évoluent avec le temps, formant une gigantesque structure filamentaire appelée la « toile cosmique ».

Les défis physiques

Relier notre connaissance de la physique – notamment les équations qui gouvernent l’évolution de la matière noire et de l’énergie noire – aux données sur les positions et les spectres lumineux des galaxies requiert des ressources en calcul considérables. Les observations les plus récentes couvrent des volumes absolument gigantesques : de l’ordre de celui d’un cube de 12 milliards d’années-lumière de côté. Comme la distance typique entre deux galaxies est seulement de quelques millions d’années-lumière, cela nous conduit à simuler environ mille milliards de galaxies pour reproduire les observations. Dans les dix prochaines années, la mission Euclid et l’observatoire Vera Rubin permettront d’obtenir des informations sur plusieurs milliards de galaxies.

Pour pouvoir suivre la physique de la formation de ces galaxies, la résolution spatiale devrait être de l’ordre d’une dizaine d’années-lumière. Idéalement, les simulations devraient donc avoir un « rapport d’échelle », proche d’un milliard – c’est-à-dire que la plus grande échelle physique du problème est un milliard de fois plus grande que la plus petite échelle physique du problème. Aucun ordinateur existant ou même en construction ne peut atteindre un tel but.

En pratique, il faut donc avoir recours à des techniques approximatives, consistant à « peupler » les simulations avec des galaxies fictives mais réalistes. Cette approximation est d’autant plus justifiée que le calcul de l’évolution des composantes d’une galaxie, par exemple les étoiles et le gaz interstellaire, met en jeu des phénomènes très rapide par rapport à l’évolution globale du cosmos. L’utilisation de galaxies fictives requiert malgré tout de simuler la dynamique de l’univers avec un rapport d’échelle de l’ordre de 4 000, ce que les super-calculateurs actuels permettent tout juste d’effectuer.

Les développements algorithmiques et matériels ont permis d’améliorer drastiquement les simulations cosmologiques

Simuler la dynamique gravitationnelle de l’Univers est ce que les physiciens appellent un problème à 𝑁 corps. Bien que les équations à résoudre soient toutes analytiques comme dans la plupart des cas en physique, les solutions n’ont, elles, pas d’expression simple et nécessitent des techniques numériques dès que 𝑁 est supérieur à quatre. La solution numérique directe consiste à calculer explicitement les interactions entre toutes les paires de « particules », appelées aussi « corps » (d’où le nom de problème à 𝑁 corps).

Pour résoudre ce problème, le calcul des forces « par sommation directe » était privilégié en cosmologie au début du développement des simulations numériques, dans les années 1970. Avec cette méthode, le nombre d’opérations nécessaires augmente comme 𝑁2, le carré du nombre de corps, ce qui contrebalance les progrès matériels, comme l’utilisation de cartes graphiques pour le calcul parallèle.

Afin de réduire le coût numérique des simulations, l’essentiel du travail en cosmologie numérique depuis 1980 a consisté à améliorer les algorithmes. Le but recherché était de s’affranchir du calcul explicite de toutes les interactions gravitationnelles entre particules, notamment pour les paires qui sont les plus éloignées dans le volume à simuler. Ces développements algorithmiques ont permis une augmentation gigantesque du nombre de particules utilisées dans les simulations cosmologiques, en orange sur la figure 1. Et de fait, depuis 1990, l’augmentation des capacités de calcul en cosmologie a été plus rapide que la loi de Moore, les améliorations logicielles s’ajoutant à l’augmentation de la performance des ordinateurs !

La limite actuelle : la lenteur des communications entre processeurs

En 2020, avec les architectures des super-calculateurs actuels, les calculs ne sont plus limités comme avant par le nombre d’opérations que les processeurs peuvent effectuer en un temps donné, mais par la lenteur intrinsèque des communications entre les différents processeurs impliqués dans les calculs dits « parallèles ».

Dans ces techniques de calcul, un grand nombre de processeurs travaillent ensemble et de manière synchrone pour réaliser un calcul beaucoup trop complexe pour être réalisé sur un ordinateur classique. Le plafonnement des performances dû aux latences dans les communications entre processeurs a été théorisé dès 1967 dans la « loi d’Amdahl », du nom de l’informaticien qui l’a formulée. L’amélioration du « parallélisme » des algorithmes représente maintenant le principal défi à relever pour les simulations cosmologiques.

L’approche sCOLA : mieux diviser pour régner

Revenons au problème physique à résoudre : il s’agit de simuler la dynamique gravitationnelle de l’Univers à différentes échelles. À « petite » échelle, il y a de nombreux objets qui interagissent entre eux : les simulations numériques sont indispensables. Aux « grandes » échelles spatiales, c’est-à-dire si on regarde la figure 2 de très loin, il ne se passe pas grand-chose lors de l’évolution (si ce n’est une augmentation linéaire de l’amplitude des inhomogénéités). Malgré cela, avec un algorithme de simulation traditionnelle, l’effet gravitationnel de toutes les particules les unes sur les autres doit être calculé, même si elles sont très éloignées. C’est coûteux et presque inutile, car l’essentiel de l’évolution gravitationnelle est correctement décrite par des équations simples, dont la résolution peut se faire sans ordinateur.

Afin de minimiser les calculs numériques inutiles, nous utilisons un algorithme de simulation hybride (sCOLA) : analytique aux grandes échelles et numérique aux petites échelles, où les interactions à 𝑁 corps sont importantes. L’idée sous-jacente est habituelle en physique, il s’agit d’un « changement de référentiel » : la dynamique à grande échelle est prise en compte par le nouveau référentiel, tandis que la dynamique à petite échelle est confiée à l’ordinateur qui la résout par des calculs classiques du champ de gravité.

Par ailleurs, ce concept permet de « diviser pour mieux régner », en simulant des sous-volumes de taille réduite de manière indépendante, sans communication avec les sous-volumes voisins. Notre approche permet donc de représenter l’Univers comme une grande mosaïque : chacun des « carreaux » est une petite simulation qu’un ordinateur modeste peut résoudre, et l’assemblage de tous les carreaux donne le tableau d’ensemble. C’est la première fois que des simulations cosmologiques sont parfaitement parallèles, et nous avons ainsi obtenu des simulations de taille comparable à celle de l’Univers observable, à une résolution satisfaisante, tout en restant sur un centre de calcul de laboratoire.

De nouveaux calculateurs pour simuler l’Univers

Ce nouvel algorithme permet d’envisager de nouvelles manières d’exploiter les ordinateurs : chacun des « carreaux » pourrait être suffisamment petit pour tenir dans la « mémoire cache » de nos calculateurs, la partie de la mémoire à laquelle les processeurs peuvent accéder le plus rapidement, ce qui permettrait d’augmenter la vitesse de calcul et de simuler le volume entier de l’Univers extrêmement rapidement, ou à une résolution encore jamais atteinte.

On peut finalement imaginer que chacune des simulations correspondant à un « carreau » soit suffisamment petite pour être exécutée sur un téléphone portable, permettant de réaliser du calcul distribué collaboratif comme avec la plate-forme Cosmology@Home.

La Région Ile-de-France finance des projets de recherche relevant de Domaines d’intérêt majeur et s’engage à travers le dispositif Paris Région Phd pour le développement du doctorat et de la formation par la recherche en cofinançant 100 contrats doctoraux d’ici 2022. Pour en savoir plus, visitez iledefrance.fr/education-recherche.