Pembuatan gambar atau video, termasuk elemen audio, dengan perangkat komputer yang dikenal dengan teknologi media sintetis (media tiruan) dalam perfilman, telah lama menjadi komponen inti dalam menciptakan dunia sinematografi yang menawan.

Kita bisa melihat hasilnya dalam film-film terkenal termasuk seri Avatar dan Jurassic Park.

Teknologi ini bukan fenomena baru. Sejak debutnya dalam film “Vertigo” pada 1958, media sintetis telah berkembang signifikan. Ini terbukti dengan penerapannya secara penuh dalam “Toy Story” pada 1995.

Penerapan media sintetis di dunia perfilman tidak berbahaya. Ketika ditujukan untuk audiens dengan usia yang tepat dan hiburan, media ini menambah dimensi baru pada pengalaman menonton film.

Namun, kini, dengan kemajuan algoritme AI generatif, kemampuan untuk menghasilkan media sintetis tidak lagi dimonopoli oleh profesional film dan pengeditan video. Orang awam pun bisa mengakses teknologi ini untuk menghasilkan konten yang kompleks dengan cepat, mudah, dan berbiaya murah.

Salah satu masalahnya adalah media sintetis versi AI yang disalahgunakan bisa menimbulkan konsekuensi serius. Misalnya, ketika digunakan untuk menciptakan “deepfake,” yaitu konten media sintetis yang dibuat dengan tujuan menyesatkan atau melakukan kejahatan. Kita perlu meningkatkan kapasitas dan regulasi untuk mengurangi dampak negatif ini.

Dampak negatif deepfake

Ada banyak model AI generatif yang digunakan untuk membuat media sintesis. Model yang paling sering digunakan adalah tiga model berikut “(1) Encoders/Decoders” dan “(2) Generative Adversarial Networks” (GAN).

Kedua model ini memungkinkan penciptaan gambar atau video yang sangat realistis, dari pertukaran wajah hingga kreasi video binatang yang terlihat berbicara.

Lalu model ketiga, “Style Transfer” yang menawarkan kapabilitas untuk menyisipkan nuansa artistik ke dalam foto atau video, mengonversi gambar biasa menjadi karya seni yang estetis.

AI telah membuka jalan bagi inovasi dalam media sintetis, meskipun terkadang menciptakan konten yang begitu nyata sehingga sulit dibedakan apakah audio atau video yang dihasilkan palsu atau asli.

Deepfake ini bisa berupa audio dan video yang sebenarnya palsu tapi tampak nyata, ditambah lagi dengan narasi-narasi yang sensitif dan memanipulasi psikologi manusia.

Contoh nyata dari dampak negatif ini terjadi pada 2022, ketika video deepfake Presiden Ukraina Volodymyr Zelensky, beredar luas. Ketika ia terlihat mengajak warga Ukraina menyerah kepada Rusia. Kejadian serupa terjadi pada 2023 dengan tersebarnya video deepfake Presiden Rusia Vladimir Putin yang mengklaim Rusia akan diserang oleh Ukraina.

Di Slovakia, audio deepfake jurnalis Denník N, Monika Tódová digunakan untuk mendiskreditkan media dengan menyebarluaskan percakapan palsu tentang manipulasi pemilihan umum pada 2023.

Sayangnya audio ini menyebar luas di media sosial pada saat masa tenang, dan pihak yang berwenang di Slowakia tidak bisa membantahnya. Akibatnya terjadi keresahan publik dan pesta demokrasi di Slowakia ternodai.

Tiga insiden di atas menunjukkan bagaimana deepfake dapat memicu kepanikan dan kebingungan di tengah situasi yang sudah tegang.

Dampak deepfake tidak hanya terbatas pada ranah sosial dan politik; kejahatan finansial juga menjadi arena yang rawan. Ini terjadi pada 2019, ketika seorang eksekutif perusahaan energi di Inggris tertipu oleh audio deepfake yang menirukan suara salah satu atasannya. Penipuan ini menyebabkan kerugian finansial yang signifikan, setara Rp3,7 miliar.

Kejadian ini memperlihatkan bagaimana teknologi yang canggih bisa disalahgunakan untuk menipu dan mengakibatkan kerugian material yang besar. Dengan demikian deepfake punya dampak yang sangat merugikan, mulai dari privasi, fitnah, pelanggaran hak cipta, kerugian keuangan, hingga keresahan sosial.

Langkah strategis memitigasi dampak ‘deepfake’

Untuk menghadapi tantangan yang disebabkan oleh deepfake, ada beberapa langkah strategis yang bisa dilakukan.

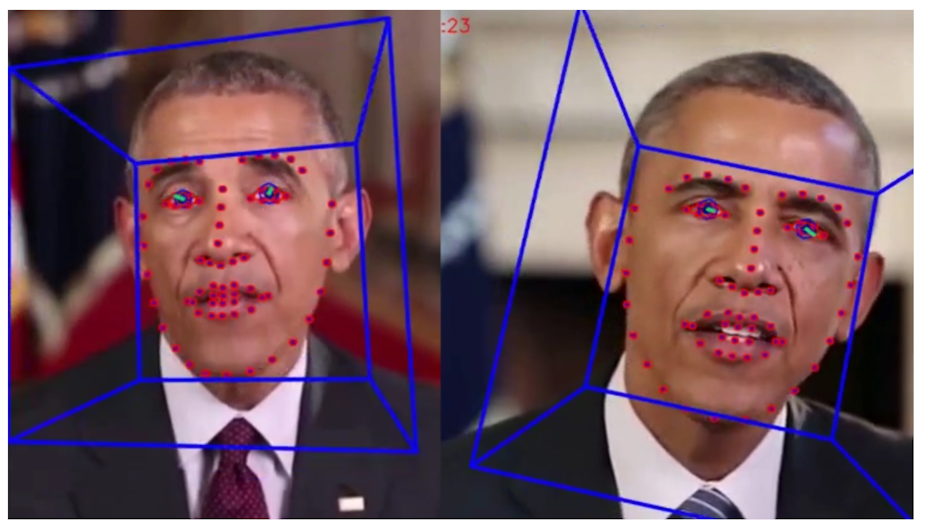

Pertama, kita perlu memahami ciri-ciri dan elemen deepfake, seperti ketidakkonsistenan dalam gambar, video atau audio. Hal ini mencakup inkonsistensi pada ekspresi wajah, arah tatapan yang tidak sesuai, pergerakan rambut yang tidak alami, perspektif wajah yang salah, pencahayaan dan bayangan yang tidak realistis, serta kurangnya ekspresi mikro wajah. Elemen-elemen ini bisa mengindikasikan deepfake. Salah satu contoh yang terkenal adalah deepfake gambar mantan Presiden Amerika Serikat Barrack Obama. Selain itu, kita juga harus kritis dengan narasi-narasi yang bisa memanipulasi psikologi kita ketika melihat deepfake tersebut.

Kedua, solusi teknologi seperti algoritme AI yang dirancang untuk mendeteksi deepfake mampu mengidentifikasi ketidakkonsistenan ini secara otomatis. Selain bisa digunakan untuk menghasilkan deepfake, AI juga bisa digunakan untuk menandai atau memfilter deepfake.

Ada beberapa repositori big data yang bisa diakses secara publik untuk melatih algoritme AI supaya bisa mendeteksi audio dan video deepfake, di antaranya Deepfake Detection Challenge, dan Celeb-DF. Para ilmuwan dan perusahaan-perusahaan teknologi multinasional saling bekerja sama untuk mengembangkan algoritme AI pendeteksi deepfake ini.

Ketiga, melibatkan langkah-langkah hukum dan kebijakan, termasuk pengembangan peraturan yang memadai dan kerja sama internasional untuk mengatasi penyebaran deepfake secara global.

EU Research Report, misalnya, mengidentifikasi lima dimensi regulasi untuk memerangi deepfake: teknologi, penciptaan, sirkulasi, target, dan audiens.

Dimensi teknologi menyoroti AI sebagai dasar dari deepfake, dengan regulasi yang diterapkan oleh Komisi Eropa. Dimensi “penciptaan” menekankan pada pelaku dan alat yang digunakan untuk membuat deepfake.

Aspek “sirkulasi” merujuk pada penyebaran deepfake melalui platform dan kanal tertentu. Aspek “target” fokus pada korban deepfake, sementara dimensi “audiens” fokus kepada pendidikan publik untuk mengenali dan memahami bahaya deepfake.

Pelajaran lainnya bisa diambil dari Badan Keamanan Siber Cina yang telah menetapkan peraturan pada Januari 2023 untuk mengatur deepfake.

Tujuan peraturan ini untuk mengekang penyalahgunaan deepfake dengan mewajibkan persetujuan (consent), memverifikasi identitas pengguna model AI yang digunakan untuk membuat media sintetis. Selain itu, juga untuk memerangi disinformasi, memastikan kepatuhan hukum, dan mewajibkan konten untuk ditandai sebagai media sintetis guna menjaga kepercayaan publik terhadap informasi digital, dan mencegah penipuan.

Keempat, peningkatan kesadaran publik dan pendidikan adalah kunci untuk mempersenjatai masyarakat dengan pengetahuan untuk membedakan antara konten asli dan palsu. Meningkatkan kesadaran tentang bahaya konten manipulatif dapat membuat masyarakat menjadi konsumen informasi yang lebih kritis melalui lokakarya, kampanye media, dan kurikulum pendidikan.

Pada tataran global, beberapa platform menyediakan pendidikan publik untuk mengenali dan menghindari bahaya deepfake, di antaranya, MIT Media Literacy, Digital Media Literacy for All, The Washington Post Fact Checker Guide to Manipulated Videos, CNN Deepfake Explained, dan Microsoft Spotting Deepfake.

Di Indonesia sudah ada inisiatif serupa, seperti panel ahli cek fakta Pemilu 2024 yang dikelola oleh The Conversation Indonesia, dan Cek Fakta.

Terakhir, pentingnya platform repositori media yang dipercaya dan mekanisme autentikasi, misalnya seperti Reality Defender, dan Content Authenticity Initiative. Platform ini memainkan peran krusial dalam menjaga integritas informasi dengan menyediakan sumber yang terverifikasi dan dapat diandalkan. Ini juga termasuk penggunaan watermark digital dan teknologi lain untuk memastikan keaslian konten.

Melalui implementasi langkah-langkah strategis ini, kita bisa meminimalkan penyebaran deepfake yang meresahkan publik, melindungi integritas diskursus publik dan kebenaran informasi.