Nadie puede negar que, en la evolución exponencial de la inteligencia artificial, el deep learning ha sido uno de los protagonistas más distinguidos. Este tipo de aprendizaje automático –machine learning–, que imita la forma en que el cerebro humano adquiere ciertos tipos de conocimientos, ha sido el motor detrás de muchos avances significativos en campos que van desde el reconocimiento de voz y de imágenes hasta la mejora de los sistemas de recomendación en plataformas de streaming y comercio electrónico.

Sin embargo, a medida que la tecnología avanza y las necesidades de la sociedad se transforman, surgen voces que proclaman que el deep learning podría estar llegando a sus últimos momentos, en aras de nuevas técnicas más transparentes.

Y es que una de las mayores críticas apunta a su naturaleza inherentemente opaca. Estos modelos, especialmente aquellos con arquitecturas complejas y profusas capas de redes neuronales, son difíciles de interpretar. A medida que un algoritmo de deep learning “aprende” de los datos, realiza ajustes en sus parámetros internos. Entender cómo estas modificaciones afectan a las decisiones finales entraña una dificultad considerable.

Esta “caja negra” en la toma de decisiones se ha convertido en un punto de fricción significativo, especialmente en aplicaciones donde la transparencia y la rendición de cuentas son cuestiones de especial relevancia.

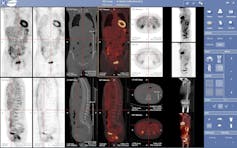

Pongamos como ejemplo un médico o un juez que usan un algoritmo de aprendizaje profundo para complementarse a la hora de abordar el diagnóstico de un paciente o el veredicto de un acusado. En principio, este profesional obtendrá del modelo de IA el resultado, la conclusión, pero no los pasos que ha seguido hasta hacer la consideración final. Por este motivo, es difícil su uso actual en la toma de decisiones complejas.

Razones éticas y legales

La creciente demanda de entender los procesos que hay detrás de la IA está enraizada en un conjunto diverso de preocupaciones, que abarcan desde la ética hasta la legalidad. La implementación de regulaciones como la Ley de la Inteligencia Artificial en la Unión Europea, recientemente aprobada, subraya la importancia de que los sistemas sean transparentes, explicables y justos.

Con ello, no solo busca proteger los derechos de los individuos, sino también fomentar la confianza en las tecnologías de aprendizaje automático, al asegurar que se puedan entender y cuestionar sus decisiones. En este sentido, el deep learning, con su intrincada red de cálculos y su dificultad para la transparencia, choca directamente con estos principios y cada vez se va convirtiendo en un desafío mayor.

Alternativas menos opacas

Así, la necesidad de sistemas más transparentes y explicables está remodelando las prioridades de investigación y desarrollo, con un impulso por buscar alternativas que no sacrifiquen el rendimiento, pero que ofrezcan una mayor claridad en su funcionamiento interno.

Una de estas nuevas vías es la apuesta por técnicas de explicabilidad por diseño, que integran la capacidad de explicación en el corazón mismo de los modelos de IA. Se trata de programas que buscan no solo mejorar la interpretación de los modelos existentes, sino también crear nuevos tipos de algoritmos que sean intrínsecamente más transparentes.

Por otro lado, la comunidad científica está trabajando en otra alternativa viable: modelos híbridos que combinan elementos de aprendizaje profundo con enfoques más tradicionales de la inteligencia artificial, como los sistemas basados en reglas o la lógica simbólica. Esta opción pretende equilibrar la capacidad de generalización y el rendimiento del deep learning con la claridad y la explicabilidad de los métodos más antiguos.

En cualquier caso, parece que la tendencia es avanzar hacia técnicas más estructuradas y menos dependientes de datos masivos, como el aprendizaje por refuerzo y el aprendizaje federado.

Estos enfoques ofrecen caminos alternativos para desarrollar sistemas inteligentes que pueden ser más fáciles de auditar y entender.

El machine learning está lejos de ser lineal o predecible y, aunque el deep learning ha dominado el campo durante años, estamos viendo que su posición no está asegurada. Es probable que se diversifiquen los enfoques de esta tecnología, donde la efectividad se mide no solo en términos de precisión o eficiencia, sino también en la capacidad de los modelos para ser comprendidos y cuestionados. Será fundamental para poder cumplir, de manera adecuada y más fácilmente, con las diferentes regulaciones en IA que se están empezando a desarrollar en todo el mundo.

En los próximos años seremos testigos de grandes cambios… esto es solo el principio. Nadie tiene una bola de cristal para garantizar al 100 % hasta dónde llegaremos en la evolución de los sistemas de inteligencia artificial. Trabajemos conjuntamente para intentar conseguir que dicha evolución tenga el impacto más positivo posible tanto a nivel profesional, como en las personas.