Définie de manière relativement floue sur le plan épistémologique, l’ère du big data se caractérise par deux volontés intrinsèquement liées : d’une part la recherche de l’exhaustivité et d’une résolution fine (spatiale, temporelle, individuelle…) dans la production de données ; d’autre part l’absence d’a priori dans leur utilisation pour bâtir des modèles mathématiques et informatiques, qui sont jugés à l’aune de leur pouvoir prédictif.

L’explosion des moyens d’enregistrement des données et le foisonnement de nouvelles approches d’analyse multiplient les applications possibles en science, dans l’industrie et pour l’aide à la décision. Si la volonté de produire et de conserver des données exhaustives et finement résolues existe depuis plusieurs dizaines d’années dans certains domaines (météorologie, finance…), la vague actuelle est inédite dans la multiplicité et la diversité des activités transformées par l’essor de cette démarche.

Produire de la donnée ne coûte pas cher

Trois évolutions ont permis cette transformation. D’abord la production de la donnée est aujourd’hui peu coûteuse, permettant d’installer des capteurs observant le fonctionnement d’un objet ou donnant des informations sur son environnement (température, luminosité), mais elle est également douée d’ubiquité, en ce sens qu’il est possible de recueillir des informations variées sur l’usage ou les réactions des utilisateurs.

La baisse des coûts de télécommunication et l’augmentation des débits a ensuite permis de simplifier le recueil des données, réduisant le temps entre leur production et leur mise à disposition pour exploitation. Enfin, le stockage des données a connu deux évolutions primordiales, d’une part la baisse constante de son coût unitaire, d’autre part le développement de systèmes de fichiers distribués (comme HDFS, SciDB) favorisant le passage à l’échelle à coût quasi linéaire (une multiplication par deux de l’espace de stockage est réalisée, sans effet de seuil majeur, en doublant le nombre de machines nécessaires).

Accumuler des données, oui, mais dans quel but ?

La connaissance et la valeur ne découlent pas directement de l’accumulation de données. Ainsi de nouveaux rôles sont apparus dans les organisations, pour, par exemple, assurer l’intégrité et la qualité des données, ou encore formuler une démarche analytique à partir d’une question scientifique ou d’une problématique industrielle. L’ère du big data se caractérise en partie par son pragmatisme, conduisant les data scientists à minimiser l’utilisation d’a priori dans la construction des modèles et à mesurer leur qualité par leur pouvoir prédictif.

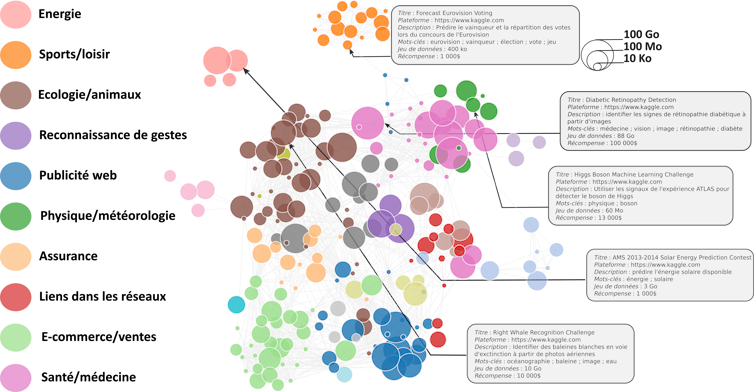

Ces modèles sont omniprésents dans nos vies. Ils influencent le résultat de nos recherches sur Internet, les publicités que nous voyons ou les produits culturels qui nous sont recommandés. Plus largement, ils interviennent dans des domaines économiques variés, par exemple en médecine pour aider à l’interprétation de certaines données ou dans la domotique pour doter les thermostats de capacités d’adaptation aux habitudes des occupants d’un logement.

Passer des données aux modèles prédictifs

La démarche de modélisation prédictive se fait généralement en trois temps : d’abord les données sont accumulées pour définir des caractéristiques mesurables ou découlant de mesures (taux de CO2, luminosité, niveau de bruit moyen dans un logement…) et choisir la variable à prédire (1/0 pour la présence/absence dans un logement) ; puis un algorithme d’apprentissage modélise les relations statistiques entre les caractéristiques et la variable et établit un modèle prédictif ; enfin, en phase d’exploitation, ce modèle est utilisé sur de nouvelles caractéristiques pour inférer la variable à prédire.

Dangers et verrous

L’analyse de gros volumes de données, à la recherche de corrélations sur lesquelles baser un système prédictif, n’est pas dénuée de risques. On peut observer des corrélations fallacieuses quand le jeu de données d’apprentissage n’est pas représentatif de son contexte d’exploitation (biais d’apprentissage) ou quand les données sont multipliées, ce qui augmente la probabilité de découvrir des relations qui ne sont que du bruit. Ces deux observations militent pour la création de systèmes interprétables, permettant aux exploitants de comprendre la décision générée.

Enfin, certains verrous limitent l’utilisation des méthodes d’analyse prédictive dans certains contextes. Ainsi on peut mentionner quelques axes de recherche : l’apprentissage incrémental (apprentissage couplé à l’acquisition), l’interprétabilité des décisions et le développement de modèles assurant la confidentialité des données d’apprentissage.

Pour aller plus loin : Les biais d’apprentissage.

Cet article est publié en partenariat avec le CEA dans le cadre de la nouvelle formule du magazine Clefs dont le premier numéro, consacré au Big Data, sera disponible à partir du 15 juin.