Les réseaux sociaux sont devenus les « places publiques numériques » de notre époque. Ils permettent la communication et l’échange d’idées à l’échelle mondiale. La nature non réglementée de ces plates-formes y a toutefois permis la prolifération de contenus préjudiciables, de désinformation et de discours haineux.

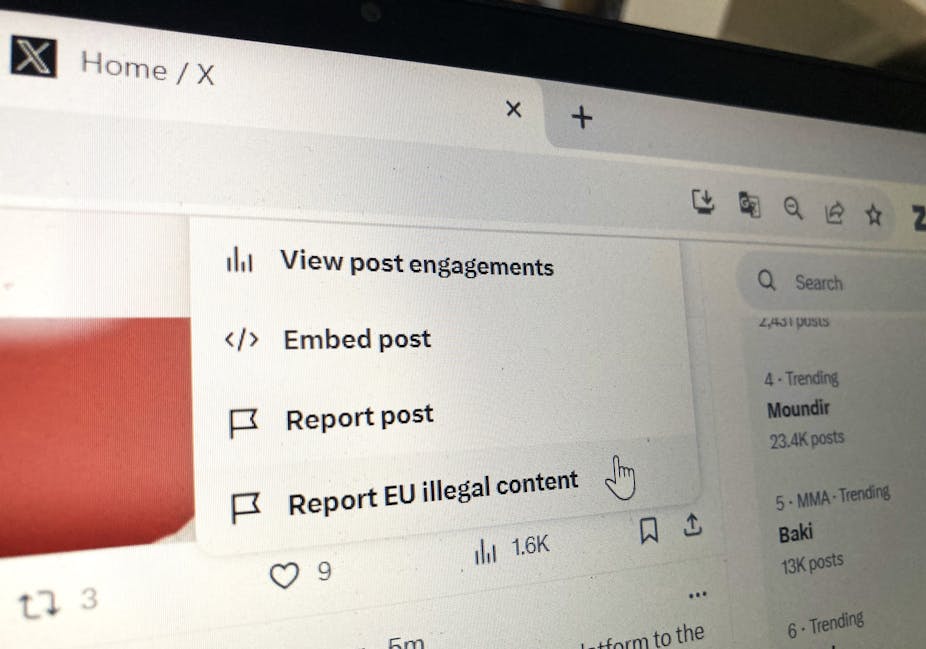

Bien qu’il s’avère difficile de réglementer le monde en ligne, une voie prometteuse a été ouverte par le Digital services act (DSA), adoptée en novembre 2022. Le règlement est entré en vigueur depuis le 25 août dernier pour les plates-formes les plus importantes et vaudra pour toutes à partir du 17 février prochain.

Cette loi prévoit que des « signaleurs de confiance » (« trusted flaggers ») rapportent certains types de contenus problématiques aux plates-formes, qui doivent alors les retirer dans les 24 heures. Qu’en attendre étant donnée la rapidité et de la complexité de la dynamique virale des médias sociaux ? Pour le savoir, nous avons simulé l’effet de la nouvelle règle, dans une recherche publiée dans la revue Proceedings of the National Academy of Sciences.

Nos résultats montrent que cette approche peut effectivement réduire la diffusion de contenus préjudiciables. Nous proposons également quelques pistes pour une mise en œuvre optimale des règles.

Modérer après 24h n’est pas inefficace

Nous avons pour cela utilisé un modèle mathématique de propagation de l’information pour analyser la manière dont les contenus préjudiciables sont diffusés sur les réseaux sociaux. Chaque message préjudiciable y est traité comme un « processus ponctuel auto-excitant ». Cela signifie qu’il attire de plus en plus de personnes dans la discussion au fil du temps et génère d’autres messages préjudiciables, dans un processus de bouche-à-oreille. L’intensité de l’autopropagation d’un message diminue, certes, avec le temps. Toutefois, s’il n’est pas contrôlé, sa « progéniture » peut générer d’autres progénitures, ce qui conduit à une croissance exponentielle.

Dans notre étude, nous avons utilisé deux mesures clés pour évaluer l’efficacité du type de modération prévu par la loi sur les services numériques : le préjudice potentiel et la demi-vie du contenu. Le potentiel de nuisance d’un message représente le nombre de descendants nuisibles qu’il génère. La demi-vie du contenu estime le temps nécessaire pour que la moitié de tous les « descendants » du message soient générés. Autrement dit, nous évaluons à la fois le nombre de messages haineux ou de désinformation généré par un message à la racine et leur vitesse d’apparition.

Nous avons constaté que les mécanismes mis en place par le DSA peuvent réduire efficacement le préjudice, même sur les plates-formes dont la demi-vie du contenu est des plus courtes, comme X (anciennement Twitter). Bien qu’une modération plus rapide soit toujours plus efficace, nous avons observé qu’une modération même après 24 heures pouvait encore réduire le nombre de descendants nuisibles jusqu’à 50 %.

Par ailleurs, plus la demi-vie est longue, plus le temps de réaction efficace s’allonge : une intervention plus tardive permet encore d’éviter de nombreux posts ultérieurs préjudiciables. Un temps de réaction plus tardif est également plus efficace pour les contenus dont le potentiel de nuisance est plus élevé. Bien que cela semble contre-intuitif, par ailleurs, nos résultats indiquent qu’il est pertinent de cibler la génération des descendants : cela rompt le cycle du bouche-à-oreille.

Cibler les efforts

Des recherches antérieures ont montré que les outils fondés sur l’intelligence artificielle peinent à détecter les contenus préjudiciables en ligne. Les auteurs de ces contenus sont en effet souvent au fait du fonctionnement des outils de détection et adaptent leur langage pour éviter d’être repérés. L’approche de la modération prévue par la loi sur les services numériques repose ainsi sur le marquage manuel des messages par des « signaleurs de confiance », qui disposent néanmoins d’un temps et de ressources limités. Pour tirer le meilleur parti de leurs efforts, les signaleurs doivent donc se concentrer sur les contenus à fort potentiel de nuisance.

[Plus de 85 000 lecteurs font confiance aux newsletters de The Conversation pour mieux comprendre les grands enjeux du monde. Abonnez-vous aujourd’hui]

Les plates-formes de réseaux sociaux emploient déjà des équipes de modération de contenu, et nos recherches suggèrent que les principales d’entre elles ont déjà suffisamment de personnel pour appliquer la législation de la loi sur les services numériques. Des questions se posent toutefois quant à la sensibilité culturelle du personnel existant, car certaines de ces équipes sont localisées dans des pays différents de la majorité des auteurs de contenu qu’elles modèrent.

Le succès de la législation dépendra ainsi de la nomination de signaleurs de confiance ayant des connaissances culturelles et linguistiques suffisantes, de la mise au point d’outils pratiques de signalement des contenus préjudiciables et de la garantie d’une modération en temps utile.

Alors que les plates-formes de médias sociaux continuent de façonner le discours public, il est essentiel de relever les défis posés par les contenus préjudiciables. Nos recherches sur l’efficacité de la modération des contenus préjudiciables en ligne offrent des indications aux décideurs politiques. En comprenant la dynamique de la diffusion des contenus, en optimisant les efforts de modération et en mettant en œuvre des réglementations telles que la loi sur les services numériques, nous pouvons aspirer à une place publique numérique plus saine et plus sûre, où les contenus préjudiciables sont atténués et où le dialogue constructif prospère.