Cet article est publié dans le cadre de la première édition du Festival des idées, un événement organisé du 15 au 19 novembre 2016 par USPC et dont The Conversation est partenaire.

Doit-on toujours se plier à ce que les autres nous disent de faire ? Bien sûr que non. Tout le monde sait ça. Du coup, les robots du futur doivent-ils toujours obéir à nos ordres ? Au premier abord, on pourrait penser que oui, tout simplement par ce que ce sont des machines et qu’elles ont été construites pour ça. Mais pensez un peu à toutes les situations où vous n’exécuteriez pas aveuglément n’importe quel ordre – et mettez les robots à votre place.

Pensez-y, dans les cas suivants :

-

Un robot auxiliaire de vie à qui son propriétaire souffrant de pertes de mémoire demande de laver le « linge sale », alors que ledit linge sort à peine de la machine à laver.

Un petit de maternelle demandant à sa nounou-robot de balancer un ballon à travers la fenêtre.

Une étudiante demandant à son robot-prof de faire tous ses devoirs à sa place.

Un robot ménager à qui les propriétaires débordés demandent de faire fonctionner la poubelle, même si des couverts sont coincés dedans.

Il y a de nombreux cas où des robots reçoivent des ordres qui ne devraient pas être satisfaits parce qu’ils aboutiraient à des résultats peu désirés. Mais toutes ces situations ne seront pas forcement inoffensives, même si les ordres donnés apparaissent anodins.

Imaginez un robot-voiture sommé de faire machine arrière tandis qu’un chien dort sur l’allée derrière lui, ou qu’un robot-cuisinier doive prendre un couteau et marcher en avant alors qu’il est positionné derrière un chef bien humain. Les commandes sont simples mais les conséquences peuvent être terribles.

En tant qu’humains, comment éviter les conséquences négatives de l’obéissance des robots ? Si conduire autour du chien n’avait pas été possible, la voiture n’aurait pas dû bouger du tout. Et de la même manière, si éviter de poignarder le chef n’était pas possible, le robot aurait dû arrêter de marcher ou de prendre le couteau au début.

Dans tous les cas, il est crucial pour les machines autonomes de détecter les dommages potentiels que leurs actions pourraient occasionner et y remédier, soit en tentant de les éviter, ou, si le mal ne peut être évité, en refusant de se plier aux ordres humains. Comment apprendre à des robots à dire « non » quand il le faut ?

Comment les robots peuvent-ils comprendre ce qu’il va se passer ?

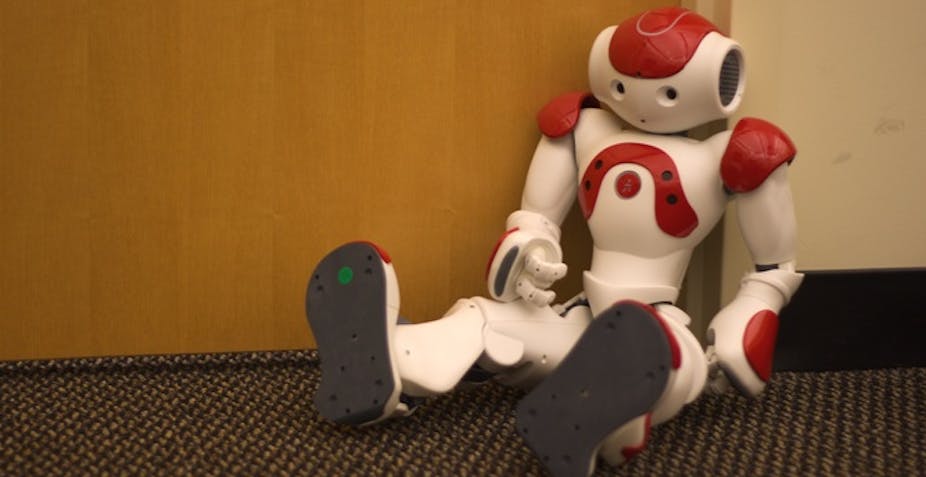

Dans notre laboratoire, nous avons commencé à développer des contrôles robotiques capables de faire des déductions simples à partir des commandes des humains. Il s’agit de déterminer si le robot doit appliquer les instructions comme demandé ou les rejeter, car elles violeraient un principe éthique auquel le robot est programmé pour obéir.

Dire à des robots comment et quand – et pourquoi – désobéir est plus facile à dire qu’à faire. Anticiper les conséquences négatives d’une action n’est pas qu’une simple affaire de court terme. Une balle jetée par la fenêtre peut finir dans le jardin sans que personne ne soit blessé. Mais cette balle peut finir sur une rue animée pour ne jamais être retrouvée, et même causer un accident de voiture. C’est le contexte qui fait toute la différence.

Il est difficile pour les robots d’aujourd’hui de déterminer s’il peut lancer une balle – pour jouer à la balle au prisonnier avec un enfant – et quand ce n’est pas acceptable – par la fenêtre ou dans la poubelle. C’est d’autant plus difficile si l’enfant essaie de piéger le robot en feignant de jouer au ballon, puis, évitant la balle, la laissant passer par la fenêtre.

Expliquer la moralité et les lois aux robots

Comprendre ces dangers demande de connaître une masse significative d’éléments de contexte (dont le fait que jouer à la balle devant une fenêtre ouverte peut la faire passer au travers). Cela demande au robot non seulement d’analyser les conséquences d’une action en tant que telles, mais aussi de jauger les intentions des humains derrière les ordres.

Pour gérer les subtilités de ces instructions – bien intentionnées ou pas – les robots doivent être capables de raisonner explicitement sur les conséquences des actions et de les comparer aux normes sociales et morales établies pour déterminer ce qui, ou non, est désirable et légal. Comme nous l’avons vu, notre robot suit une règle générale qui stipule : « Si on t’ordonne d’effectuer une action, et qu’il est possible qu’elle puisse causer du tort, alors tu es autorisé à ne pas la faire ». Faire le lien entre les obligations et les permissions permet au robot de raisonner sur les possibles conséquences d’une instruction, et de déterminer si elles sont acceptables.

En général, les robots ne devraient jamais accomplir des actes illégaux, de même que des légaux mais qui ne sont pas désirables. Ainsi, ils auront besoin de se représenter les lois, les normes sociales et même la façon de se comporter pour être capable de déterminer si la conséquence d’un ordre, ou l’ordre en lui-même, est susceptible de violer l’un de ces principes.

Bien que nos programmes sont encore loin de ce qui est nécessaire pour permettre aux robots d’appliquer les exemples ci-dessus, notre système actuel prouve un point essentiel : les robots doivent être capables de désobéir pour obéir.