Les arythmies cardiaques touchent des millions de personnes et provoquent 300 000 morts chaque année en Europe. Leurs mécanismes sont étudiés par simulation numérique mais nécessitent des calculs à une échelle encore jamais atteinte. En effet, le cœur humain comporte 10 milliards de cellules, chacune équipée d’un million de canaux ioniques capables de changer leur comportement en moins d’une nanoseconde. Faire des calculs au niveau de ces canaux représente une force de calculs dépassant de loin les capacités de calculs des ordinateurs actuels.

Comme l’arythmie cardiaque, de nombreux autres phénomènes sont difficiles à comprendre à cause de l’énorme complexité des systèmes qui les portent. Citons par exemple l’évolution du climat, l’étude des atomes ou du fonctionnement des systèmes microbiens.

Alors, les scientifiques transforment les phénomènes en « modèles » (des ensembles d’équations) qui seront par la suite transcrits sous forme de programme informatique appelé « simulation ». Les résultats de ces simulations peuvent ensuite être comparés avec des observations, afin de vérifier ou améliorer les modèles, et avec eux notre compréhension des phénomènes.

Pour obtenir des résultats en temps raisonnables, les simulations sont effectuées sur des ordinateurs surpuissants : des supercalculateurs.

Qu’est-ce qu’un supercalculateur ?

Les supercalculateurs sont des machines ayant la capacité d’effectuer des calculs complexes beaucoup plus rapidement qu’un ordinateur personnel. Par exemple, le supercalculateur Frontier, le plus rapide du monde actuellement, peut calculer jusqu’à un milliard de milliards d’opérations par seconde ! Une performance appelée « exascale » en référence à l’exaflop qui correspond à un milliard de milliards de calculs numériques.

Read more: Calcul haute performance et ordinateurs superpuissants : la course à l’« exascale »

Depuis les années 1990, les ordinateurs sont devenus un milliard de fois plus puissant, et avec ce supercalculateur dépassant pour la première fois la barrière mythique de l’exaflop, de nouvelles opportunités s’ouvrent notamment aux scientifiques, principaux utilisateurs de ces machines.

Cependant, ces supercalculateurs représentent d’énormes investissements (le supercalculateur Jean-Zay installé à l’Idris a par exemple coûté environ 25 millions d’euros) et des dépenses énergétiques avec des factures qui peuvent atteindre des millions d’euros par an : alors, pourquoi toujours chercher à en augmenter la puissance ?

Des modèles mathématiques à la simulation de ce qui nous entoure

Certaines simulations nécessitent une grande puissance de calcul. C’est le cas par exemple des simulations qui tentent de comprendre l’évolution du climat, les maladies, anticiper les séismes ou plus généralement les catastrophes naturelles ou encore l’écoulement de l’air autour des ailes d’un avion. Ces phénomènes complexes engendrent plusieurs heures ou jours de calculs sur de grosses machines dites « de production » (des « mini-supercalculateurs » qui servent à tester les applications avant de les lancer sur de vrais supercalculateurs), avec énormément de données. Seul un supercalculateur va pouvoir effectuer de tels calculs en un temps raisonnable, traiter de gros volumes de données et augmenter la précision des simulations.

Pour comprendre comment c’est possible, imaginons qu’on ait un mur de dix kilomètres de long à construire et deux maçons à disposition pour faire ce travail. Pour construire efficacement le mur, le travail sera réparti entre les deux maçons de manière équitable et de manière à ce que les maçons puissent poser des briques du mur sans se gêner. Si nous avons maintenant deux-cents maçons à notre disposition, répartir le travail peut devenir complexe. Le mur sera construit beaucoup plus vite mais sa construction demandera de la logistique en amont pour que tous les maçons travaillent efficacement.

C’est la même chose avec les simulations. Le mur représente ici une simulation et les maçons des processeurs à notre disposition dans un supercalculateur. Plus on a de processeurs, plus la simulation devrait aller vite. Par contre, il y a un gros travail de planification nécessaire pour que ces processeurs se partagent les ressources et communiquent efficacement entre eux. Il faut éviter le plus possible que les processeurs s’attendent entre eux, ce qui ralentit l’application.

[Près de 80 000 lecteurs font confiance à la newsletter de The Conversation pour mieux comprendre les grands enjeux du monde. Abonnez-vous aujourd’hui]

La cardiologie : un domaine de choix pour l’utilisation des supercalculateurs

Même si aujourd’hui, la puissance de calcul nécessaire pour simuler le fonctionnement d’un cœur humain depuis l’échelle de ses cellules n’existe pas encore, l’augmentation de la puissance des supercalculateurs permet aux modèles déjà existants de gagner en précision.

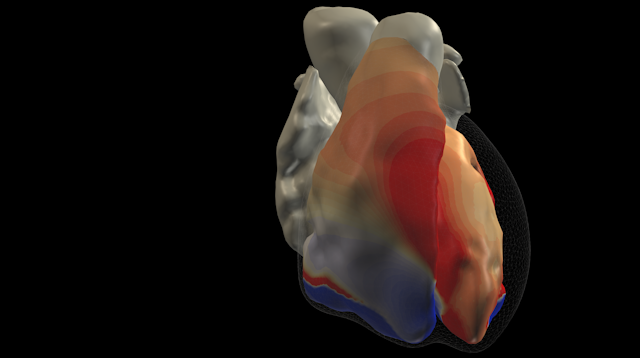

Par exemple, le projet européen MICROCARD dans lequel est impliqué le centre Inria de l’université de Bordeaux utilise les nouvelles architectures des supercalculateurs pour comprendre comment les cellules du cœur génèrent des arythmies lorsqu’elles sont malades ou mal couplées entre elles et comment on peut détecter une situation dangereuse en observant les signaux électriques mesurés sur un patient.

Dans un cœur sain, les connexions entre cellules sont si fortes que les cellules semblent agir comme une seule grande cellule. On appelle ce phénomène un « syncytium ». Les modèles numériques utilisés aujourd’hui considèrent le tissu cardiaque comme un syncytium. Ils sont ainsi composés de millions d’éléments, chaque élément représentant quelques centaines de cellules.

Dans un cœur endommagé, il manque des cellules et des connexions. Si une cellule musculaire cardiaque meurt, elle n’est pas remplacée par une autre. De ce fait, le muscle ne se comporte plus comme un syncytium à certains endroits.

Pour comprendre cette situation, il est important de modéliser le cœur cellule par cellule. On n’aura plus plusieurs cellules par élément mais des milliers d’éléments par cellule, permettant de représenter la forme des cellules individuelles et leurs connexions avec les cellules voisines. Un tel modèle cellule par cellule sera cent mille fois plus complexe que les modèles actuels, qui nécessitent déjà l’utilisation de supercalculateurs.

Les calculs qui sont associés à la simulation de ce problème ne peuvent se faire que sur des supercalculateurs exascalaires. Avec un supercalculateur comme Frontier, la compréhension de l’électrophysiologie cardiaque est maintenant possible. Certains supercalculateurs sont accessibles aux chercheurs et chercheuses, d’autres sont réservés à des instituts et projets collaboratifs.